AI 赛道人满为患,眼看AI服务器里最烧钱的GPU都齐了,但竟然会因为“缺芯”,导致无法出货。

“海外找了一千片,还没凑齐,太难了。”“我们找供应商采购AI服务器,就因为主板缺了博通的PCle Switch 4.0芯片,没法安排出货,现在他们正在到处找。”

以博通SS26为代表的PCle Switch芯片,最近需求异常多,不仅现货少,报价还从5500美元飙到20000美元!也难怪AI服务器会涨价,一入AI深似海,原来不止是GPU价格在涨……

1、博通SS26,为什么这么抢手?

2、为什么缺?有替代吗?

3、AI服务器还带动哪些芯片增长?

博通SS26价格涨至2万美元

AI相关GPU和服务器缺货潮还在持续发酵,英伟达、AMD等GPU大厂持续加单,而大模型下AI服务器集众多硬件与零部件于一身,GPU这头的短缺还在填补,另一头又开始短缺,你永远不知道下一个缺的又是什么部件。

今年6月初开始,博通的PCle Switch在市场上就有了缺货迹象。

相关型号包括博通SS26、SS24、SS23打头的芯片,询价热度较高,市场上找货需求异常多,如SS26-0B00-02、SS24-0B00-02、SS23-0B00-02,其中SS26规格高,最为缺货,规格低一些的SS24、SS23虽然没那么缺,也有不少人在找货。

关于高端的SS26-0B00-02市场价格,业内人士告诉我们,目前其香港原装报价是5500 USD/ 片(26片起购),到了深圳现货市场,报价高达1.8万-2万 USD/片(含税),还不保证原装。

芯世相观察到,某些型号带目标价格也不一定能挖到现货。比如SS23-0B00-02,有终端在海内外到处找货,接受5000元单价,急需现货。

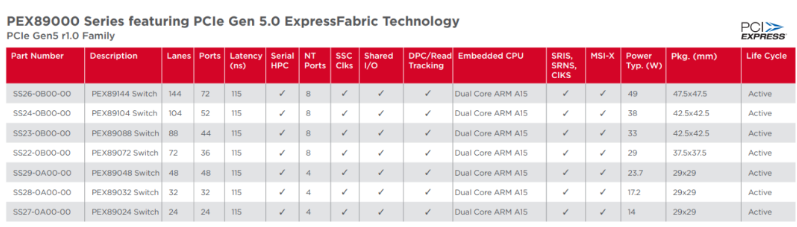

以上芯片型号,都属于博通PEX89000 PCIe Gen 5.0系列交换机,目前是其针对数据中心和云平台的PCI快速交换机中的最新系列产品,应用于 ML/AI 和服务器/存储应用的可组合超大规模计算系统。

规格最高的SS26-0B00-00具有144个PCIe Gen 5.0通道,可实现高达9216 Tb/s(1152 GB/s)的原始带宽。

因而博通的PEX89000系列交换机,可以说是为先进计算而生的AI芯片了。

博通PEX89000 PCIe Gen 5.0系列交换机型号,来源:broadcom.com

PCle(PCI-Express,peripheral component interconnect express),即外围组件快速互连,是一种高带宽扩展总线。简单来说,总线就是电脑内部进行交互的公用通道,可以理解为各种交通道路,PCle就是其中的一种。

如果大家有自己装机的经历,就会在主板上看到水平的PCle插槽。

PCle通常用于连接显卡、固态硬盘以及采集卡和无线网卡等外设,也常用于服务器平台,也越来越多地被用作存储和GPU互连解决方案。

主板上的PCle通道分为x1、x2、x4、x8 和x16几种配置,通道数量越多意味着带宽越高,插槽也就更长。我们组装电脑时,GPU就通常安在x16插槽中。

PCle既可以作为接口,又可以作为通道。当它是接口的时候,可以插带PCle接口的任何外设:显卡、无线网卡、USB接口、固态硬盘、声卡等等,这个插槽里面,就有我们的PCle Switch芯片。

PCIe Switch,即 PCIe 开关或 PCIe 交换机,主要作用是实现 PCIe 设备互联,像服务器要实现CPU、GPU等组件互联,就离不开它。

有了PCle Switch,PCle从端对端的连接,变成多条总线连接,有效拓展了链路,形成一个高速的PCIe互联网络,从而实现多设备通信。

PCle Switch的高可拓展性、低功耗、低延迟、高可靠性、高灵活性等优势,使之广泛应用于机器学习、人工智能、超融合部署和存储系统中。

PCIe Switch连接多条PCIe总线,来源:PCI-SIG官网,中金公司研究部

计算机内部包含PCle等各种总线协议,让我们拆开一台AI服务器内部看看。

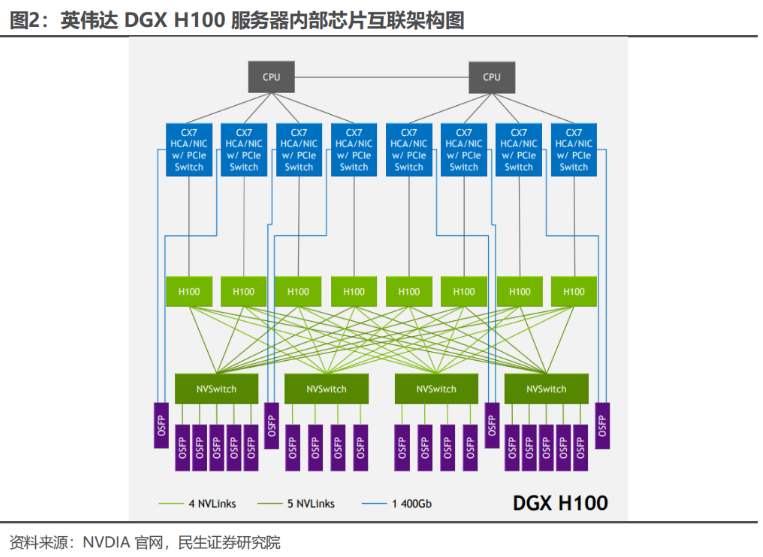

以 NVIDIA HGX H100 8-GPU为例,8 块 H100 GPU在全新的 FP8 精度下 AI 性能比上一代高 6 倍,可提供 900GB/s 的带宽,该服务器内部包含NVLink、PCIe和QPI等主板总线。

NVLink方面,8张 GPU(H100)之间互联主要通过4个第三代NV Switch 芯片来实现。每个H100 GPU共通过18个NVLink 4.0(5+4+4+5)连接到4个NVSwitch芯片。每个NVSwitch相当于一个完全无拥塞的交换机,与8张H100 GPU卡实现完全连接。

NVLink是英伟达基于PCle Gen4研发的新技术,是点对点的高速互联技术,支持多达 16 个 GPU 或 CPU 的连接,可实现大规模的并行计算和深度学习训练。

英伟达A100、H100等GPU可以分PCle和NVLink两种版本,GPU互联时用的是不同通道。PCle版本的GPU互联便是通过PCIe通道完成的,借助PCIe switch,系统可以实现CPU-GPU,GPU-GPU的连接。

多个GPU之间连接,PCIe仅64GB/S,4个以上的GPU互联就较为吃力了。随着AI和高性能计算需求不断增长,需要更大的互联带宽,NVLink的带宽是双向带宽,如NVLink 3.0的带宽可以达到7200 Gbit/s,即900 GB/s,明显优于PCIe,而且在每GPU连接数量上限也高达18张,GPU的性能就可以发挥到最大化,这也就是为啥黄老板说买得越多省越多。

PCle方面,GPU与CPU之间通过PCIe 5.0总线实现互联。图中蓝色方块为 IP 网卡(CX7),既是网卡又能发挥PCIe Switch(5.0)扩展功能,成为 CPU 与H100(GPU)之间互联的桥梁。CPU之间则仍使用QPI总线进行通信。

可以看出,一台AI服务器要实现GPU-CPU互联,甚至是GPU之间的互联,都离不开PCIe Switch芯片。来自博通SS26等芯片的需求普遍集中在服务器终端,它们也正是用于AI服务器的PCle Switch芯片。

“AI服务器要PCle 4.0、5.0及以上版本,做这类产品的厂商少,价格很贵。”一位服务器专业人士告诉我们。

为什么缺,有替代吗?

伴随着AI 服务器、GPU等需求的增加,作为连接部件的PCle Switch需求也起来了。目前用于AI服务器的4.0、5.0版本属于PCle Switch中的先进版本。专业人士告诉我们,PCle Switch要看其支持的Lanes和Ports,参数越高,价格越贵。

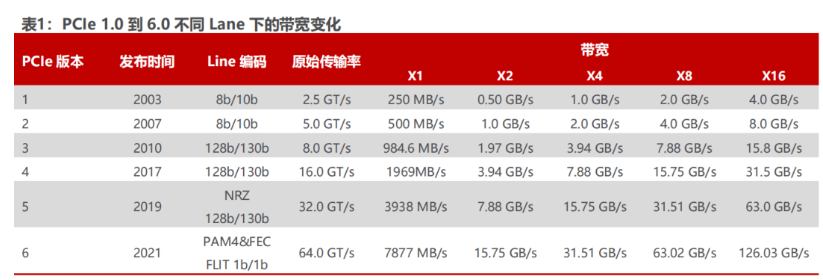

PCIe最早由Intel于2001年提出,2003年正式推出PCIe 1.0版本,到2022年已迭代至6.0。根据PCI-SIG官网,伴随人工智能、自动驾驶、AR/VR等具有高运算要求的应用快速发展,处理器I/O带宽每三年实现翻番,也促使PCIe基本上按照3年一代的速度更新演进。

PCle基本上平均每3年更新一代,其单通道速率都在翻倍增长,总带宽也在提高。2022年PCI-SIG 正式发布PCIe 6.0 规范,这是PCIe问世以来变化最大的一代,每通道数据传输速率从PCIe 5.0的32GT/s翻番至64GT/s,除了带宽和效率的提升,还具有更低的延迟。2022年6月,PCI-SIG联盟宣布PCIe 7.0版规范,单条通道(x1)单向可实现128GT/s传输速率,计划于2025年推出最终版本。

别看PCIe 7.0版规范都出来了,博通的PCle Switch 5.0最近也被大家到处扫货,但业内人士告诉我们,市场上对PCIe 5.0的需求实际上还没起来,“其一是目前大规模出货的CPU基本是PCIe 4.0,其二是英伟达A100/A800和国产GPU、NPU等也都是PCIe 4.0。”

目前用量大的仍是高端PCIe 4.0,且缺货比较严重,在现货市场,原来单价2000-3000 RMB现在涨到大几千,甚至1万元,供货周期变长很多。而低端4.0产品需求越来越少,普通服务器为实现更大灵活度也往中高端走,供货渠道不多,供货周期也变长了,但价格只要小几千元。

因此博通PCle Switch 5.0这类芯片的起量还没那么快,“预计国内要在2024年下半年起量,到时候CPU才基本升级到PCIe 5.0。另外,英伟达H800也支持5.0版本,一些加速卡应该会加入到5.0生态。”

那么一台AI服务器要用多少PCle Switch芯片,用量有多大?

我们从前文对AI服务器的内部拆解可以看出,CPU和GPU之间互联的需求量不多,主要的用量在GPU之间的互联。

如果你用的是A100 80G PCIE的8卡AI服务器,这里面8张A100互联可能就要用到大量的PCle Switch,而NVLink版本的带宽升级更大,GPU之间不用PCle Switch。

不过,NVLink仅用于GPU之间,最终传输结果给GPU还是走PCle,“目前服务器都还是X86架构,所以基本都是PCle的IP,Intel本身并未支持NVLink。”CPU与GPU互联离不开PCle Switch。

带宽的高低,也是决定PCle Switch用量的重要因素,“还要看主带宽是多少,比如它里面做了一个PCIe 5.0,64x,也就是说它可以同时产生64路PCle 5.0的x1(带宽),那需求量就极大了。”

全球PCle Switch三大供应商,博通、微芯、祥硕科技三家,共占有全球约58%的份额。据博通官网介绍,博通是PCI Express交换领域的领导者,出货量超过10 亿个,公司正通过行业领先的交换机系列以及新的重定时器解决方案推动数据中心连接的发展。

如果要替换这颗博通芯片,目前可替代的微芯也面临缺货,而国产即便有替代,国外主板厂一般也不采用。据悉,美国一家新公司xconn-technology刚推出样品,明年这时候就有对应产品上市。

随着PCIe 在服务器中应用越来越广泛,PCIe Switch 的市场需求也被带动起来。根据QYResearch的统计及预测,2021年全球 PCIe 芯片市场销售额达到了 7.9 亿美元,预计2028年将达到 18 亿美元,年复合增长率(CAGR)为 11.9%。

我们知道,除了苹果,英伟达、博通和AMD最近乘着AI热潮都在台积电积极投片生产。

这波博通PCIe Switch热,与英伟达用于AI服务器的GPU缺货逻辑基本一致,那就是尚未实现大规模出货,近期才追加扩产,一段时间内面临供应不足。

博通也是受益于AI时代来临的芯片大厂之一,除了与苹果持续合作外,博通还陆续获得了谷歌、Meta 等大厂的高级 ASIC 芯片订单。博通作为通信巨头,这些订单估计包括了PCIe Switch在内的不少通信相关AI芯片。

博通FY23Q2财报显示,博通目前AI营收占半导体营收约15%,预计FY24提升至25%;与其他芯片厂商相比,博通在2-4月的单季营收同比增长了 8%,芯片业务表现超出市场预期。

博通还表示,AI相关部分产品从生产到交付需要超过6个月。博通CEO认为,未来传统计算与AI计算会齐头并进,AI增长更快,传统计算不会消亡,未来增长一半来自传统业务,一半来自AI。

结 语

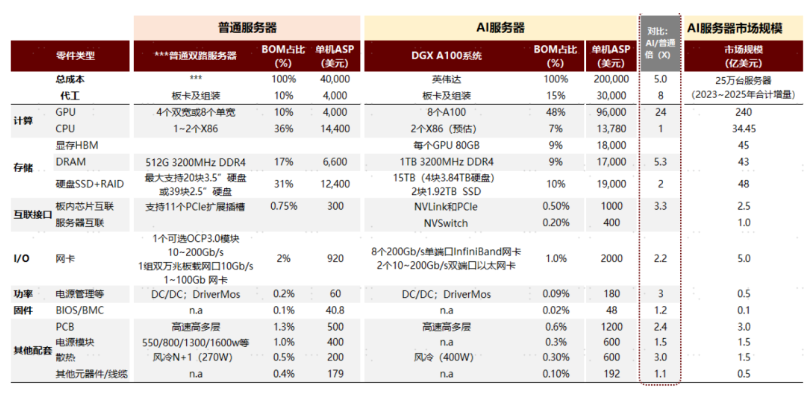

据报道,AI服务器将大幅推升服务器平均出货单价(ASP)由8500至9000美元上涨到1万美元以上,AI服务器主要集中在今年第四季大量出货。

AI训练的庞大数据,需要在各芯片之间高速无拥塞互联。英伟达自己的NVLink、NVSwitch市场规模有限,而传统CPU生态中的PCIe接口芯片及其他高速互联芯片市场相对开放,PCIe Switch作为数据中心低功耗、高性能解决方案的核心一环,有望迎来高增长。根据Transparency市场调研机构数据,2019-2027年CAGR约15%,2027年全球PCIe Switch市场规模或将达到92亿美元。

除了PCle Switch,AI服务器需求带动服务器产业链上各环节价值增长,业内人士测算,相较普通双路服务器,AI服务器核心器件单机价值量提升倍数由高到低依次为GPU(24x)、DRAM(5.3x)、板内互联接口芯片(3.3x)、电源管理(3x)、散热(3x)、PCB(2.4x)、网卡(2.2x)和SSD(2x)。

普通和AI服务器价值量拆解及对比、AI服务器不同出货量假设下各环节的市场规模测算,来源:IDC,英伟达,中金公司研究部

AI需求强劲,但需要看清的是,AI不足以撑起整个半导体行业的增长,近期晶圆代工厂们降价、热停机动作亮起警示灯,目前半导体行业仍处于消费电子需求低迷阴影之下,复苏缓慢。

以博通为代表的高端AI芯片市场,同样是个玩家有限的小池子,它的稀缺与涨价反映一段时间内高端AI芯片供不应求,对于芯片市场多数从业者来说,行情尚在缓慢复苏,可遇而不可求,唯有继续积极开发新产品、新技术、新客户,找到新的增长点,才是以不变应万变的关键所在。

器件型号:AT90CAN128-16AUR

器件型号:AT90CAN128-16AUR

器件型号:DS3231SN#

器件型号:DS3231SN#

下载ECAD模型

下载ECAD模型.jpg?x-oss-process=image/resize,m_fill,w_400,h_298)